在當今數據驅動的時代,大數據技術已成為眾多行業轉型升級的關鍵引擎。學習大數據技術,遠不止于理解其概念與架構,更重要的是熟練掌握一系列核心工具,以實現高效、可靠的數據處理。這不僅是技術能力的體現,更是將數據價值轉化為業務洞察力的實踐基礎。

一、 理解大數據技術的基石:從概念到生態

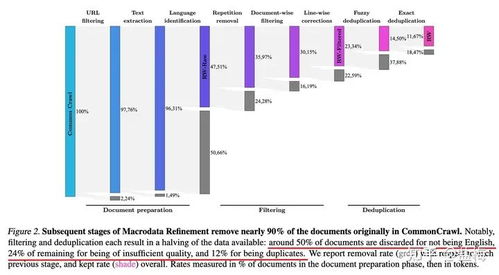

學習大數據技術,首先需明晰其核心特征——通常以“4V”(Volume體量、Velocity速度、Variety多樣、Value價值)概括。這決定了傳統數據處理方式難以為繼,催生了以Hadoop、Spark等為代表的分布式計算框架。這些框架構成了大數據處理的底層基礎設施,其設計哲學(如分而治之、移動計算而非移動數據)是理解所有上層工具的邏輯起點。

二、 掌握數據處理的核心工具鏈

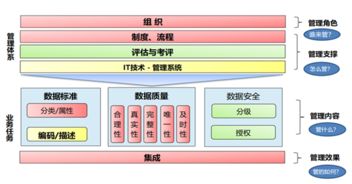

數據處理是大數據技術棧中承上啟下的核心環節,涉及采集、存儲、計算、分析等多個階段,每個階段都依賴特定的工具集。

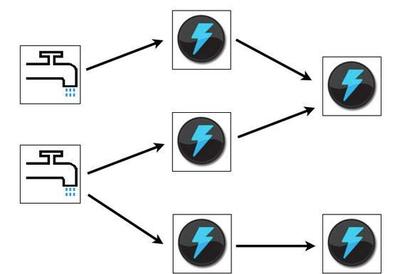

- 數據采集與傳輸工具:數據處理的源頭。需要掌握如Apache Kafka(高吞吐量分布式消息隊列)、Flume(日志收集)、Sqoop(關系數據庫與Hadoop間數據傳輸)等,它們負責從各類源頭實時或批量地將數據匯聚到數據湖或數據倉庫中。

- 數據存儲與管理工具:數據的安居之所。HDFS(Hadoop分布式文件系統)是經典的批量數據存儲基石;而面對實時查詢,則需要掌握HBase(列式數據庫)、Cassandra等NoSQL數據庫。數據倉庫工具如Hive(提供SQL接口查詢HDFS數據)和云原生數據湖倉一體方案(如Delta Lake、Iceberg)也日益重要。

- 數據計算與處理引擎:這是發揮數據價值的核心“發動機”。

- 批處理:Apache Spark憑借其內存計算和豐富的API(Scala、Java、Python、R),已成為批處理的首選,其性能遠超經典的MapReduce。

- 流處理:對于實時數據流,需掌握Apache Flink(低延遲、高吞吐、狀態精確一次處理)或Spark Streaming(微批處理模型)。

- 交互式查詢:工具如Presto、Impala,能夠對海量數據進行亞秒級交互式SQL查詢。

- 數據調度與協調工具:確保復雜的數據處理流程有序、自動化運行。Apache Airflow(以代碼定義工作流)和DolphinScheduler是任務調度的主流選擇;而ZooKeeper則提供分布式協調服務,保障集群的可靠運行。

三、 構建高效數據處理能力的關鍵實踐

僅僅知道工具名稱遠遠不夠,真正的掌握體現在:

- 環境搭建與集群管理:能夠在本地或云上(如AWS EMR、阿里云EMR)熟練部署、配置和維護一個大數據集群,理解各組件間的協作關系。

- 編程與開發:深入使用至少一種主流語言(推薦Scala或Python)進行Spark/Flink應用開發,編寫高效、健壯的數據處理作業。

- 性能調優:能夠根據數據特性和業務需求,對作業進行性能調優,例如調整Spark的并行度、內存分配、選擇合理的存儲格式(如Parquet、ORC)與壓縮算法。

- 問題排查與調試:熟練查看各類工具的運行日志(如YARN日志、Spark UI),快速定位并解決數據處理過程中的故障與瓶頸。

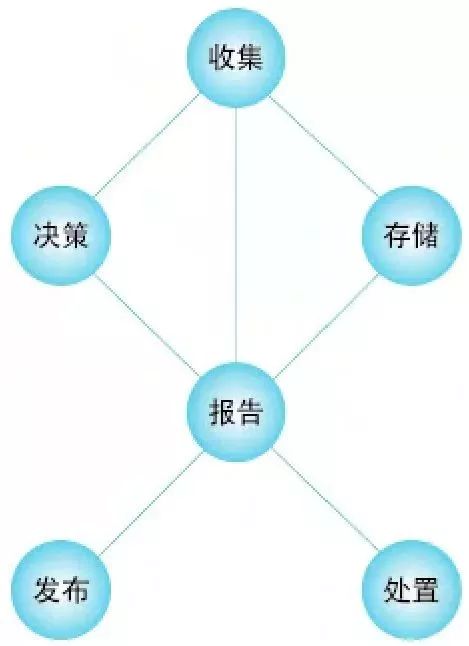

- 融入數據治理與質量:在數據處理流程中融入數據質量檢查、元數據管理(如Apache Atlas)和數據血緣追蹤的意識,確保產出數據的可信度。

四、 學習建議與路徑規劃

建議采取“理論->核心工具->系統實踐”的路徑:

- 夯實理論基礎:理解分布式系統原理、CAP定理、數據模型等。

- 聚焦核心工具:優先深度掌握Hadoop(HDFS, YARN)、Spark(Core, SQL, Streaming)和一門數據庫(如Hive或HBase)。

- 動手實踐項目:從搭建環境開始,完成一個端到端的數據處理項目,例如“網站日志分析系統”,涵蓋數據采集(Kafka)、存儲(HDFS/Hive)、處理(Spark)、可視化等全流程。

- 拓展與深化:根據興趣方向,深入流處理(Flink)、云原生大數據架構或特定領域(如機器學習庫MLlib)。

學習大數據技術是一場結合深度與廣度的旅程。對數據處理工具的熟練掌握,是將大數據宏偉藍圖變為現實生產力的關鍵階梯。唯有通過持續的理論學習、工具實踐和項目錘煉,才能在大數據的浪潮中游刃有余,真正駕馭數據,賦能決策與創新。