在當今人工智能的浪潮中,大型語言模型(如GPT、BERT等)的崛起標志著自然語言處理領(lǐng)域的重大突破。這些模型卓越性能的背后,往往離不開一個關(guān)鍵但常被忽視的環(huán)節(jié)——數(shù)據(jù)處理。數(shù)據(jù)處理不僅是模型訓練的起點,更是決定模型質(zhì)量、性能及倫理安全的核心因素。本文旨在探討大模型預訓練中數(shù)據(jù)處理的各個環(huán)節(jié)及其背后的深層思考。

一、數(shù)據(jù)采集:廣度與質(zhì)量的平衡

數(shù)據(jù)采集是構(gòu)建預訓練數(shù)據(jù)集的第一步,其核心挑戰(zhàn)在于如何在數(shù)據(jù)的廣度(數(shù)量與多樣性)與質(zhì)量(準確性、代表性)之間找到平衡。

- 廣度追求:大模型需要海量數(shù)據(jù)以學習語言中的復雜模式和世界知識。數(shù)據(jù)來源通常包括互聯(lián)網(wǎng)公開文本(如網(wǎng)頁、書籍、學術(shù)論文)、專業(yè)領(lǐng)域語料以及多語言資料。廣泛的數(shù)據(jù)覆蓋有助于模型獲得通用知識,減少偏見,并提升其泛化能力。

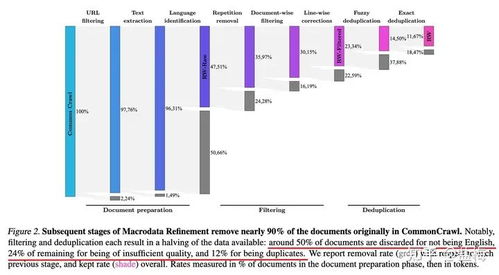

- 質(zhì)量把控:并非所有數(shù)據(jù)都適宜訓練。低質(zhì)量數(shù)據(jù)(如垃圾信息、錯誤內(nèi)容、重復文本)可能引入噪聲,影響模型性能。因此,數(shù)據(jù)清洗成為必要步驟,包括去重、過濾不當內(nèi)容、修正格式錯誤等。數(shù)據(jù)的時效性也需考慮,特別是在快速變化的領(lǐng)域(如科技、新聞)。

二、數(shù)據(jù)預處理:標準化與增強的策略

預處理是將原始數(shù)據(jù)轉(zhuǎn)化為模型可讀格式的關(guān)鍵環(huán)節(jié),其目標在于提升數(shù)據(jù)的一致性和學習效率。

- 文本標準化:包括分詞(將文本拆分為詞或子詞單元)、大小寫統(tǒng)一、特殊字符處理等。例如,BERT使用的WordPiece分詞法能有效處理未登錄詞,而GPT系列采用的字節(jié)對編碼(BPE)則平衡了詞匯表大小與表示能力。

- 數(shù)據(jù)增強:對于數(shù)據(jù)稀缺的領(lǐng)域或任務,可通過回譯、同義詞替換、句子重組等方式生成新樣本,以增加數(shù)據(jù)多樣性,防止過擬合。但需注意,增強過程應保持語義一致性,避免引入誤導信息。

- 格式對齊:對于多模態(tài)模型(如結(jié)合文本與圖像),需將不同模態(tài)數(shù)據(jù)對齊到統(tǒng)一表示空間,這涉及復雜的特征提取與映射技術(shù)。

三、數(shù)據(jù)分布與偏差:倫理與社會責任的考量

數(shù)據(jù)并非中性,它往往反映現(xiàn)實世界中的社會、文化與歷史偏差。在大模型預訓練中,忽視數(shù)據(jù)分布問題可能導致模型放大偏見,引發(fā)倫理風險。

- 偏差識別:通過統(tǒng)計分析,檢測數(shù)據(jù)在性別、種族、地域、文化等方面的不平衡。例如,若訓練數(shù)據(jù)中男性相關(guān)文本遠多于女性,模型可能生成帶有性別偏見的輸出。

- 去偏策略:可采取重采樣、生成平衡數(shù)據(jù)、或在訓練目標中加入公平性約束來緩解偏差。構(gòu)建多樣化、包容性的數(shù)據(jù)源(如涵蓋少數(shù)群體語言或文化內(nèi)容)是根本之道。

- 透明化:公開數(shù)據(jù)來源、處理方法和已知偏差,有助于用戶理解模型局限,并促進社區(qū)監(jiān)督。

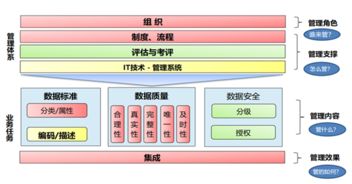

四、數(shù)據(jù)安全與隱私:合規(guī)性與技術(shù)防護

隨著數(shù)據(jù)法規(guī)(如GDPR)的完善,預訓練中的數(shù)據(jù)安全與隱私保護變得至關(guān)重要。

- 去標識化:移除或模糊文本中的個人身份信息(如姓名、地址),以降低隱私泄露風險。技術(shù)手段包括命名實體識別與替換、差分隱私等。

- 版權(quán)合規(guī):確保數(shù)據(jù)使用不侵犯知識產(chǎn)權(quán),可通過使用開源數(shù)據(jù)集、獲取授權(quán)或依賴合理使用原則(但需法律評估)來實現(xiàn)。

- 安全過濾:在預處理中嵌入內(nèi)容安全機制,過濾暴力、仇恨言論等有害信息,以構(gòu)建更健康的模型輸出。

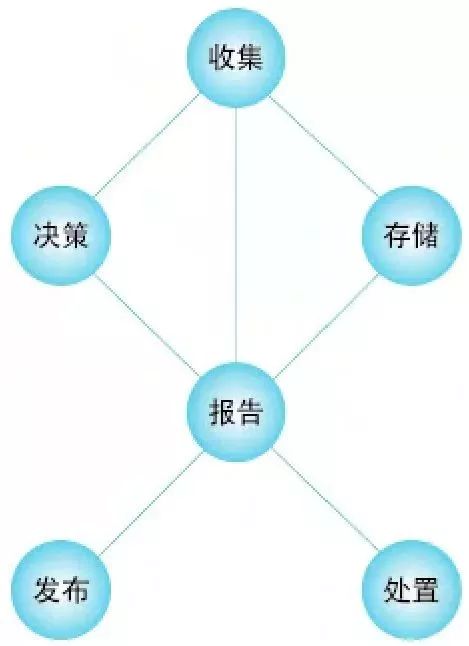

五、數(shù)據(jù)評估與迭代:持續(xù)優(yōu)化的閉環(huán)

數(shù)據(jù)處理并非一勞永逸,而是一個需要持續(xù)評估與迭代的動態(tài)過程。

- 質(zhì)量評估指標:除了傳統(tǒng)的統(tǒng)計指標(如詞匯多樣性、句子長度分布),可引入模型驅(qū)動的評估,例如用初步模型測試數(shù)據(jù)性能,或通過人工標注驗證關(guān)鍵樣本。

- 反饋循環(huán):根據(jù)模型在實際應用中的表現(xiàn)(如用戶反饋、錯誤分析),反向優(yōu)化數(shù)據(jù)采集與處理策略。例如,若模型在特定領(lǐng)域表現(xiàn)不佳,可針對性補充相關(guān)語料。

- 可擴展性設(shè)計:隨著數(shù)據(jù)量增長,需采用分布式處理框架(如Hadoop、Spark)和自動化流水線,以提升效率并減少人為錯誤。

數(shù)據(jù)作為模型之基

數(shù)據(jù)處理在大模型預訓練中扮演著基石角色。它不僅是技術(shù)過程,更涉及倫理、法律與社會責任的綜合考量。隨著模型規(guī)模的擴大與應用場景的深化,數(shù)據(jù)處理將朝著更智能化(如自動清洗與增強)、更公平化(如偏差動態(tài)監(jiān)測)和更安全化(如隱私保護技術(shù)融合)的方向發(fā)展。唯有在數(shù)據(jù)層面深思熟慮,才能鑄就既強大又負責任的人工智能模型,真正賦能人類社會。