在數據科學和氣象研究的交叉領域,Jupyter Notebook已成為一個不可或缺的工具,它以其交互性、可視化和可重復性,極大地簡化了氣象數據的分析處理流程。本文將以一個典型的氣象數據集為例,詳細闡述在Notebook環境中進行數據加載、清洗、探索性分析和基礎可視化的完整過程。

一、環境搭建與數據加載

我們創建一個新的Jupyter Notebook,并導入必要的Python庫:pandas用于數據處理,numpy用于數值計算,matplotlib和seaborn用于數據可視化。氣象數據通常以CSV、NetCDF等格式存儲。這里假設我們有一個名為weather<em>data.csv的文件,包含日期、溫度、濕度、降水量、風速等字段。使用pandas的read</em>csv函數可以輕松加載數據:import pandas as pd<br />weather<em>df = pd.read</em>csv('weather<em>data.csv')

加載后,通過weather</em>df.head()和weather_df.info()快速查看數據的前幾行、列名、數據類型及缺失值情況。

二、數據清洗與預處理

原始數據往往存在缺失值、異常值或格式不一致的問題。我們需要進行清洗以確保分析質量。

- 處理缺失值:可以使用

weather<em>df.isnull().sum()統計各列缺失值數量。對于少量缺失,可采用向前/向后填充(ffill/bfill)或插值法;對于大量缺失,可能需要刪除該列或使用均值/中位數填充。例如,對溫度列用前值填充:weather</em>df['temperature'].fillna(method='ffill', inplace=True)。 - 格式轉換:確保日期列被正確解析為datetime格式:

weather<em>df['date'] = pd.to</em>datetime(weather<em>df['date']),并可以將其設為索引以便時間序列分析:weather</em>df.set_index('date', inplace=True)。 - 處理異常值:通過描述性統計(

weather_df.describe())或箱線圖識別異常值,并根據業務邏輯進行修正或刪除。

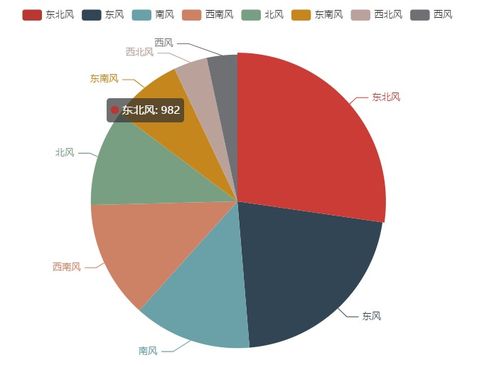

三、探索性數據分析(EDA)

清洗后的數據可以進行深入的探索,以發現潛在的模式和關系。

- 描述性統計:計算關鍵氣象指標(如平均溫度、最高風速、總降水量)的基本統計量。

- 時間趨勢分析:對溫度、降水量等變量進行重采樣,例如計算月度平均溫度:

monthly<em>avg</em>temp = weather_df['temperature'].resample('M').mean(),并用折線圖可視化其長期變化趨勢。 - 變量間關系:使用散點圖矩陣或熱力圖探索溫度、濕度、風速等變量之間的相關性。例如,計算相關系數矩陣:

correlation<em>matrix = weather</em>df.corr(),并用seaborn.heatmap可視化。

四、基礎可視化

可視化是理解氣象數據的重要手段。在Notebook中,我們可以內聯顯示圖表。

1. 折線圖:展示溫度隨時間的變化,可清晰看出日變化或季節趨勢。

2. 柱狀圖:比較各月的總降水量,直觀呈現降水分布。

3. 箱線圖:分析不同季節風速的分布情況,識別異常天氣。

4. 直方圖:查看濕度的頻率分布,了解其集中趨勢。

這些圖表可以通過matplotlib.pyplot或seaborn庫輕松實現,并添加標題、坐標軸標簽以增強可讀性。

五、結論與進一步方向

通過上述步驟,我們完成了對氣象數據的基本處理與分析,初步揭示了數據中的規律,如溫度的季節性波動、降水與濕度的正相關等。在Jupyter Notebook中,整個流程被記錄為代碼、輸出和注釋的有機組合,確保了分析的可重復性和可擴展性。可以在此基礎上進行更復雜的分析,如時間序列預測(使用ARIMA或LSTM模型)、極端天氣事件檢測或結合地理信息進行空間分析。Notebook的交互特性使得迭代和分享分析結果變得異常便捷,是氣象數據分析處理的理想起點。